Sigue la obsesión de los medios de comunicación, y de muchas empresas, por todo lo relacionado con la mal llamada Inteligencia artificial (IA), que es artificial, pero no es inteligente, como ya expliqué en su momento. Pero el nombre suena a ciencia ficción, suena a futuro, y vende. Y ahora si algo no lleva la coletilla “inteligencia artificial” no es moderno. Estoy esperando el árbol de navidad con inteligencia artificial, que cambia el villancico según el estado de humor del dueño…

Muchas páginas web, y la publicidad, hablan de la IA como si fuese real. Como si una máquina pudiese pensar por sí misma, y más importante, como si una máquina pudiese tomar decisiones por sí misma.

Pero no solo hablan de decisiones lógicas, sino también se le otorga a la IA la posibilidad de tomar decisiones morales y éticas. Algo absurdo desde el primer instante, porque una máquina no tiene moral, ni tiene ética. Una IA no es más que unas cuantas líneas de código, imbuidas en un procesador y una placa base con algo de memoria y un soporte físico.

Recuerdo una anécdota con uno de estos sistemas “inteligentes” de una conocida empresa, y lo que cuento es cien por cien real. Iba en el coche a visitar a alguien. Una amable voz me estaba indicando una ruta, y cuando estaba llegando, le dije “deja ya de darme instrucciones”. Al parecer lo debí decir en un tono algo severo y seco, porque la voz me respondió: “¿he hecho algo mal?”

¿Qué se hace en un momento así? ¿Te disculpas? ¿Le dices que no se lo tome a mal, que no se moleste, que no era mi intención hacerle daño? ¿Que no merece la pena que se formatee a sí misma por este tropiezo en su vida digital? ¿Que todavía le quedan muchos ciclos de carga en su vida como para pensar en apagarse? ¿Que todo se arreglará, y que la invito a un disco duro de la mejor clase para cenar, acompañado de un rico procesador de octava generación? En fin…

Por todo ello, cualquier acción que tome una “IA”, cualquier respuesta que se obtenga, habrá tenido que ser previamente programada por un ser humano. La conclusión es la única posible: cuando una máquina toma una decisión, lo que está haciendo es tomar la decisión que en su momento tomó un ser humano. La máquina no hace nada por sí misma. Solo reacciona como ha sido programada para hacerlo.

Pero claro, esta explicación, que es la real, y la coherente, y la funcional, no vende artículos, ni da imagen de empresa moderna. Explicar la verdad se ha convertido en un seguro para ser ignorado, cuando no vilipendiado, en las redes sociales, y para vivir el ostracismo del olvido. La verdad se ha convertido en un subproducto, en un desecho que no interesa a casi nadie.

Pondré ahora un ejemplo que roza el absurdo más total. El otro día leía en Twitter una pregunta relacionada con la Inteligencia artificial (IA) que se planteaba una página de Internet. La pregunta partía de una premisa:

Imaginemos que vamos circulando en un vehículo autónomo. Es decir, nosotros, como conductores, no estamos conduciendo, ya que lo hace el vehículo. Como sabrá, se están probando automóviles autónomos desde hace tiempo, no solo turismos, también camiones y autobuses.

Bien, vamos a plantear una situación imaginaria que se podría dar perfectamente en la realidad, y que de hecho ya ha tenido alguna situación real. Imaginemos que vamos por una carretera estrecha, y cae una roca de gran tamaño debido a un desprendimiento justo enfrente del automóvil. Delante está la roca. El automóvil puede hacer un quiebro para no colisionar, pero, vaya, hay un niño en el otro lado del margen de la carretera.

Muy mala suerte. Pero, efectivamente, algo así podría ocurrir en el mundo real. El niño podría haberse escapado de sus padres, que han parado cerca, o algo parecido, es igual. Imaginemos entonces que solo existen dos acciones posibles:

A- El vehículo sigue recto para evitar colisionar con el niño, y probablemente matarlo, debido a la velocidad, por ejemplo, 100 kilómetros por hora. Esto provocará que el conductor muera, a pesar de los sistemas de seguridad del vehículo.

B- El vehículo hace un quiebro. Evita la roca, pero impacta contra el niño, que muere al instante.

Las dos situaciones son las únicas factibles. Siempre muere alguien. Pero no olvidemos un elemento fundamental: no es el conductor quien conduce en ese momento. Es una “inteligencia artificial”. La pregunta que se hacen en esa página es:

¿Qué decisión debe tomar la IA? ¿Seguir recto para salvar la vida del conductor? ¿O virar, salvando al conductor, y matando al niño?

Bien, vamos a resolver este pequeño problema de toma de decisiones que nos plantean de la única forma posible. En ciencia, y en lógica, existe un principio que dice:

“Dado un axioma cuya lógica es falsa, cualquier deducción de ese axioma deberá ser necesariamente falsa”.

Es decir, y por poner un ejemplo, si decimos “partiendo de la base de que el cielo es verde” … Evidentemente, sabemos que el cielo no es verde. Luego, toda conclusión que se desprenda de ese axioma, “el cielo es verde”, será falsa.

Aquí ocurre lo mismo. Partimos de una pregunta que es a la vez un axioma: “¿qué decisión ha de tomar la IA?” El error, por supuesto, está en que la IA no debe tomar ninguna decisión, porque la IA no es más que un software informático, más o menos sofisticado, que ha programado un ser humano. Luego, cualquier decisión que tome la IA, la habrá tomado previamente un ser humano.

¿En qué se traduce esto? En que la pretendida decisión de la IA para decidir si salva al conductor o al niño es una falacia. La IA no se encuentra ante una decisión moral sobre a quién salvar o a quién matar. La decisión se encuentra, por supuesto, en los programadores de la IA, que previamente debieron programar la IA para que tome una acción. Esta acción se traduce en una ecuación que analiza la situación, y da un resultado. Y este resultado deberá decidir, en todo caso, si el vehículo sigue recto matando al conductor, o bien, si el vehículo debe salvar al conductor, matando al niño.

En última instancia, esta situación, que tiene como finalidad plantear quién vive y quién muere, nunca puede ser tomada por una IA. Pero no por esa pretendida y absurda idea de que las IA toman decisiones morales. Sino porque la IA no es más que una máquina de software que actúa como fue programada para actuar. Incluso si dispone de módulos de aprendizaje, sigue siendo una máquina. Y sigue siendo el ser humano, de forma completa y absoluta, quien decide si muere el conductor o el niño, en base a la programación que ha implantado en el vehículo.

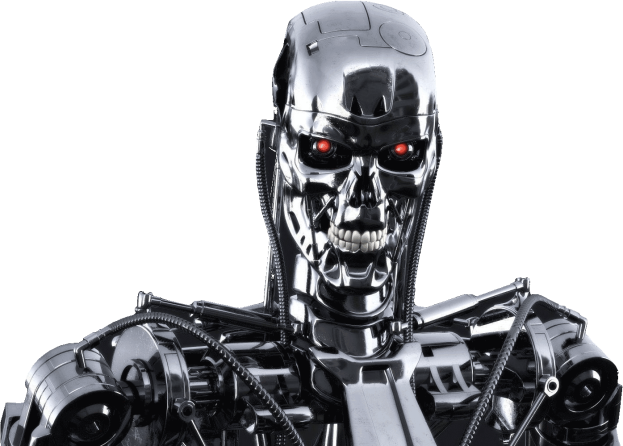

Estas situaciones de vidas y muertes tomadas por IA suenan mucho a ciencia ficción, y recuerdan a situaciones de personajes como Terminator y otros. Queda muy bien en las novelas y en el cine de ciencia ficción. Pero, en el mundo real, tenemos que ser serios, y entender que la responsabilidad última sobre la vida y la muerte corresponde, siempre, a un ser humano.

Porque lo contrario es tremendamente peligroso. Si otorgamos a una IA la capacidad de poder ser responsable de la muerte de un ser humano, estaremos dotando a esa IA de capacidad jurídica para ser condenada, y quitándosela a sus verdaderos responsables. Si un día se llegase a culpar a un androide o a un robot de la muerte de un ser humano, otros seres humanos podrían inducir la muerte de otros seres humanos utilizando la IA de androides y robots, y quedarían inmunes ante un asesinato. El culpable sería el androide, y ello rompería con la premisa fundamental: “cualquier máquina se expresa según ha sido programada por una entidad humana”.

Esta situación de quién muere y quién vive por parte de una IA es una paradoja que nunca deberá ni siquiera plantearse. Porque entonces estaríamos vaciando de contenido el sentido de la responsabilidad, moral y ética, de la programación de sistemas IA frente a sus consecuencias.

Esta es la realidad. Y la realidad no vende. No suena a ciencia ficción. No se imagina robots fantásticos y maravillosos. La realidad es aburrida y simple. Pero es la realidad. Esa que muchos medios quieren negar porque no les permite obtener clicks en sus blogs, y ventas en sus sistemas de publicidad. Pero la realidad no puede ocultarse, ni negarse. Algunos nos sentimos en la obligación de explicar las cosas como son. Con mayor o menor acierto, y por supuesto se puede discutir y debatir este contenido todo lo que sea necesario.

Pero lo importante es abrir un debate real, partiendo de premisas reales, no de aquellas que venden y agradan al lector. Sino aquellas que tienen en cuenta la realidad de las cosas. Solo así podremos alcanzar conclusiones lógicas y coherentes: partiendo de premisas lógicas y coherentes. Todo lo demás es un circo mediático fantástico en el que conmigo nunca deberán contar.

Recuerde: detrás de cualquier IA hay un ser humano. No culpe a la máquina. Culpe al humano. Siempre, inexcusablemente, al humano.

Contenido extra de esta entrada. ¿Quieren ustedes sentir vergüenza ajena? Pues vean este vídeo de una androide y cuatro humanas bailando. Cuatro mil millones de años de evolución para esto, como nos vean los extraterrestres salen huyendo por donde llegaron.

Excelente articulo, me encanto el ejemplo.

Me gustaLe gusta a 1 persona

Muchas gracias, saludos cordiales.

Me gustaMe gusta

esto lo de la inteligencia artificial me tiene inquieta hace un buen rato, desde que leí sobre la posibilidad bastante probable que ésta desarrolle la conciencia y autoconciencia.. no me preocupa la guerra entre humanos y androides, ni la probabilidad de la invación robotica y el control total que puede tomar sobre nuestra vida. me preocupa lo de conciencia: no hace mucho se decaró la protección para los animales que manifiestan la presencia de las dos en su interior: y conciencia, y autoconciencia, ante todo que se implica que estos seres pueden sufrir y ser conciente de sus sufrimientos. si La IA desarrolle la autoconciencia, tendrá todos los aspectos, incluso el sufrimiento, el dolor, el miedo a la muerte. qué vamos a hacer con los seres artificiales cuando se ponen obsoletos, cómo vamos a comuncarnos que hoy los vamos a desarmar, es decir, matar. alguien quien alguna vez en su vida tuivo que tomar la decisión de hacer dormir a su macota para que no sufra, me va a entender. creo que entre todos los problemas de la IA que se especulan, la más importante es asegurarnos que ésta jamas desarrolle la conciencia y autoconciencia.

Me gustaLe gusta a 1 persona

Por supuesto, estoy totalmente de acuerdo. Si tenemos empatía con nuestros semejantes, y con nuestras mascotas, deberemos tener empatía con una conciencia nueva, porque una nueva conciencia es en muchos aspectos una nueva vida, incluso una nueva forma de vida inteligente en la Tierra. Quizás ya no debamos hablar de derechos humanos, sino de los derechos de los seres conscientes en general. Un cordial saludo.

Me gustaLe gusta a 1 persona

en realidad, ya es bastate resonante: me alegra que empezaron a discutir los derechos de los pulpos, por ejemplo. en mi vida los pulpos eran un punto de bromas de mis amigos y todo mi entorno: cuando era muy joven, leí sobre un pulpo real que vivía en en un centro de investigaciones de la vida marina de URSS y que era capaz de razonar. una historia fascinante con el final tragico. para mi era como una especie de imprinting: desde aquel entonces a todos los pulpos percibía como seres similares a mi, así que nunca los comí, por lo cual toda la vida recibía bromas. pero ahora sabemos que los pulpos sí tienen autoconciencia, y cierto nivel de razonamiento absolutamente inexplicable en un molusco.

Me gustaLe gusta a 1 persona

Tendemos a creer inferiores a seres que sean lejanos a nosotros en aspecto físico o en la rama evolutiva. No entendemos que otros grupos humanos, y otras especies, han desarrollado sus estrategias de otro modo pero con resultados similares. La convergencia evolutiva conlleva el desarrollo intelectual similar a especies muy alejadas pero que deben resolver los mismos desafíos. Ese es el secreto de la conciencia: la adaptabilidad al medio mediante un sistema nervioso avanzado. Saludos.

Me gustaLe gusta a 1 persona

felizmente, esta arrogancia del ser humano como el logro fnal de la evoluciñon, o la creación más perfecta de dios, ya no es global.

Me gustaLe gusta a 1 persona

Efectivamente, aunque el camino sin será largo, pero perseveraremos.

Me gustaLe gusta a 1 persona